Von Pixeln zur Personalisierung: Wie Tencents HunyuanCustom die KI-Video-Erstellung neu definiert

Die leise Revolution bei der KI-Video-Erstellung

Am 8. Mai 2025 veröffentlichte Tencent ein großes Update für die Welt der generativen KI – und die meisten haben es gar nicht bemerkt. Wenn Sie aber in den Bereichen Marketing, Medien, E-Commerce oder KI-Investitionen arbeiten, ist HunyuanCustom ein Name, den Sie sich merken sollten. Diese Veröffentlichung ist nicht nur ein weiteres Modell in der überfüllten Landschaft der Video-Generierungs-Tools – es ist eine Veränderung auf Infrastruktur-Ebene. Das Modell bietet etwas, das keine offene oder geschlossene Plattform in großem Maßstab überzeugend geliefert hat: identitätskonsistente, multimodale Video-Anpassung.

In einer Welt, die zunehmend von synthetischen Medien beherrscht wird, ist die Wahrung der Authentizität einer digitalen Persona über verschiedene Bilder, Aktionen und Eingaben hinweg nicht nur eine technische Herausforderung – sie ist eine geschäftliche Notwendigkeit. Egal, ob Sie einen digitalen Markenbotschafter einsetzen, das Abbild einer Berühmtheit animieren oder Charaktere in Videoinhalten ersetzen, ohne neu zu drehen – Identitätskonsistenz ist die entscheidende Variable, die über Erfolg oder Misserfolg entscheidet.

HunyuanCustom nimmt sich dessen direkt an, mit einer Reihe architektonischer Neuerungen. Das Ergebnis? Ein Sprung nach vorn bei der Kontrollierbarkeit, Anpassung und visuellen Kohärenz – drei Säulen skalierbaren synthetischen Contents.

Warum ist das jetzt wichtig?

Video macht bereits über 80 % des Internetverkehrs aus. Generative KI wird genutzt, um alles zu beschleunigen, von der Anzeigenproduktion und Avatar-Erstellung bis hin zu virtuellen Lehrern und animierten Produktdemonstrationen. Bisher hat jedoch ein Problem eine breitere Akzeptanz eingeschränkt: die Inkonsistenz. Gesichter verändern sich von Bild zu Bild. Audio passt nicht zu den Lippenbewegungen. Die Identität verschwimmt in der Bewegung.

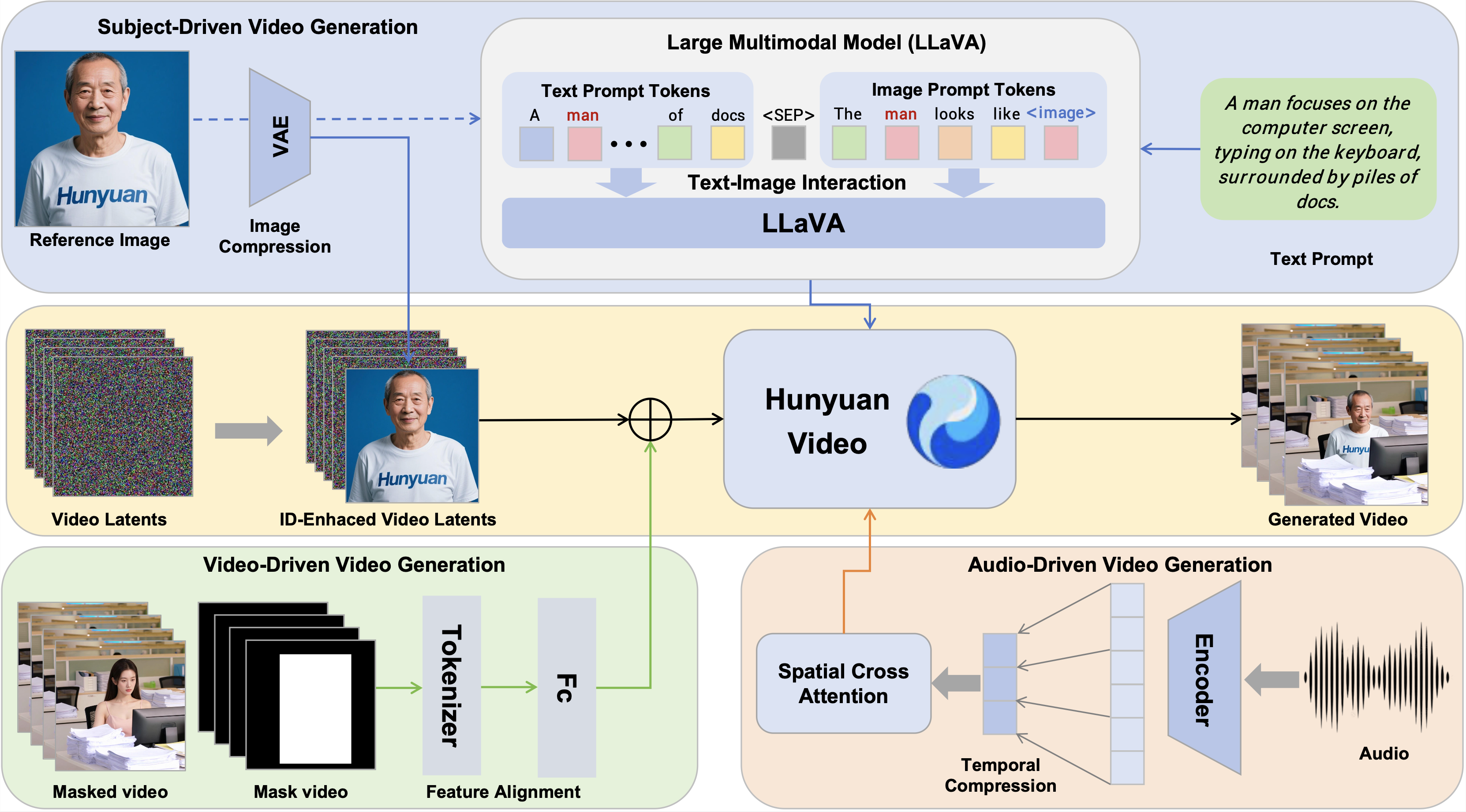

Tencents HunyuanCustom adressiert diese Schwächen direkt, indem es multimodale Eingaben (Text, Bilder, Audio, Video) integriert und sie zu einem konsistenten, kontrollierten Ergebnis zusammenfügt. Es ist mehr als nur ein Funktions-Update – es ist eine Verbesserung der Infrastruktur, auf der aufgebaut werden kann.

Für Investoren ist die Botschaft klar: HunyuanCustom ist positioniert, ein grundlegendes Modell für kommerzielle KI-Videoinhalte zu werden. Und sein Engagement für Open Source könnte das Kräfteverhältnis bei zukünftigen Marktanteilsentwicklungen beeinflussen.

Ein Blick in die Architektur: Was macht HunyuanCustom anders?

Schauen wir uns die wichtigsten Innovationen an und warum sie für Entwickler und Firmenkunden relevant sind:

1. Multimodale Konditionierung, die funktioniert

Im Gegensatz zu vielen Vorgängern, die bei komplexen Eingabekombinationen scheitern, fügt HunyuanCustom Text, Bilder, Audio und Video zu einem kohärenten Ergebnis zusammen. Egal, ob Sie einen sprechenden digitalen Zwilling eines CEOs oder ein Kleidungsmodell, das auf Umgebungsgeräusche reagiert, wünschen – dieses Modell kann es leisten.

📌 Schlüssel-Innovation: LLaVA-basierte Text-Bild-Fusion schafft ein einheitliches Verständnis von visueller Identität und verbaler Anweisung – entscheidend für natürliche Bewegung und Ausdruck.

2. Identitätskonsistenz-Engine

Das Herzstück des Systems ist das Image ID Enhancement Module. Mithilfe von VAE-Latenzen und 3D-Positions-Embeddings wird die Identität einer Person über Videobilder hinweg übertragen, ohne lediglich Gesichtsmerkmale zu „kopieren und einzufügen“. Das stellt sicher, dass die Person bei Bewegung, Verdeckung oder Ausdrucksänderungen erkennbar bleibt.

📌 Warum das wichtig ist: Frühere Modelle litten unter Ruckeln und Identitätsverlust über die Zeit. HunyuanCustoms Verbesserungen bei der zeitlichen Konsistenz beheben dies.

3. Audio ohne Abweichung

Bei traditionellen Modellen beeinträchtigt das Einbinden von Audio zur Steuerung der Lippensynchronisation oft die visuelle Identität der Person. Tencents Lösung: das Identity-Disentangled AudioNet, das pro Bild räumliche Cross-Attention anwendet und so eine präzise Synchronisation ohne visuelle Verzerrung gewährleistet.

📌 Geschäftliche Relevanz: Ermöglicht natürlich klingende virtuelle Avatare für Kundenservice, E-Learning oder interaktives Marketing.

4. Schnelle und effiziente videobasierte Bearbeitung

HunyuanCustom ermöglicht auch die Nutzung bestehender Videos als Eingangs-Quellen – zum Beispiel, um einen Hintergrundcharakter zu ersetzen oder einen neuen Sprecher in eine zuvor aufgenommene Anzeige einzufügen.

📌 Technologischer Durchbruch: Das Video-Driven Injection Module fügt kodierte Merkmale aus Referenzvideos direkt in den Generierungsstrom ein, mit minimalem Rechenaufwand.

Benchmarking des Hypes: Ist es wirklich besser?

In technischen Vergleichen mit Open-Source- und kommerziellen Plattformen wie Vidu, Pika, Keling und Skyreels führt HunyuanCustom an mehreren Fronten.

| Modell | Face-Sim (↑) | DINO-Sim (↑) | Zeitl. Konsistenz (↑) |

|---|---|---|---|

| Vidu 2.0 | 0,424 | 0,537 | 0,961 |

| Keling 1.6 | 0,505 | 0,580 | 0,914 |

| Pika | 0,363 | 0,485 | 0,928 |

| HunyuanCustom | 0,627 | 0,593 | 0,958 |

Diese Zahlen deuten auf ein Modell hin, das bei der Identitätserhaltung, dem Szenenrealismus und der zeitlichen Kohärenz überlegen ist. Das ist nicht nur ein technischer Sieg – es ist ein geschäftlicher Wegbereiter.

Praxisanwendungen mit kommerziellem Potenzial

Die Stärke von HunyuanCustom liegt in seiner Anpassungsfähigkeit für verschiedene Anwendungsfälle:

Werbung & Marketing

Marken können konsistente digitale Botschafter in lokalen Kampagnen einsetzen, komplett mit lippensynchroner Botschaft in mehreren Sprachen.

Virtuelle Anprobe & E-Commerce

Bekleidungsmarken können realistische Bewegungsdemonstrationen aus Standbildern generieren, was den Bedarf an teuren Fotoshootings reduziert.

Bildung & Training

Personalisierte Video-Trainer können für verschiedene demografische Segmente erstellt werden, wobei die visuelle und klangliche Qualität konsistent bleibt.

Videobearbeitung & Produktion

Studios können nun älteres Filmmaterial mit neuen Charakteren oder Botschaften nachrüsten, ohne neu zu drehen oder Deepfake-Artefakte zu erzeugen.

Gaming & Metaverse

Lebensechte Avatare können aus minimalem Input animiert werden, was Next-Gen-Personalisierung für virtuelle Welten ermöglicht.

Herausforderungen und Überlegungen für die Einführung

Auch wenn die Leistung vielversprechend ist, gibt es ein paar Vorsichtspunkte zu beachten:

- Hardware-Anforderungen: Das Modell empfiehlt 80 GB GPU-Speicher für optimale Ergebnisse – das bedeutet, es ist für die meisten Kreativen kein Plug-and-Play.

- Tencents Vorteil: Der Umfang und die Qualität des Systems resultieren aus Tencents Ressourcenbasis. Ähnliche Ergebnisse zu reproduzieren, könnte ohne vergleichbare Infrastruktur nicht einfach sein.

- Validierung durch Dritte: Obwohl das Modell quelloffen ist, wurden viele der Benchmark-Vergleiche intern durchgeführt. Eine breite Akzeptanz hängt von der Nachbildung und Validierung durch die Community ab.

Infrastruktur für die nächste Content-Ökonomie

HunyuanCustom ist nicht nur ein weiteres KI-Modell – es ist ein Fortschritt auf Plattform-Ebene dafür, wie Unternehmen hochwertige Videoinhalte generieren, anpassen und skalieren können. Der Schritt zur Open-Source-Veröffentlichung macht es noch disruptiver, besonders in einem wettbewerbsintensiven Markt, der von geschlossenen Systemen dominiert wird.

Für Content-Ersteller, Agenturen und Investoren stellt HunyuanCustom einen Wendepunkt dar. Mit überlegener Identitätskontrolle, multimodaler Flexibilität und Leistung auf Unternehmensniveau bietet es das Rückgrat für die nächste Phase der synthetischen Medien.