Google DeepMind enthüllt Gemini Diffusion: Ein Paradigmenwechsel in der KI-Textgenerierung

Google DeepMind hat gestern Gemini Diffusion angekündigt. Dabei handelt es sich um ein experimentelles Sprachmodell, das erstmals in Produktionsgröße den Ansatz der Bilderzeugung (vom Rauschen zum Signal) auf Text überträgt. Dieser Durchbruch verspricht eine deutlich schnellere Textgenerierung mit verbessertem Zusammenhang. Das könnte den dominanten Ansatz bei großen Sprachmodellen, der die KI-Entwicklung seit Jahren prägt, grundlegend verändern.

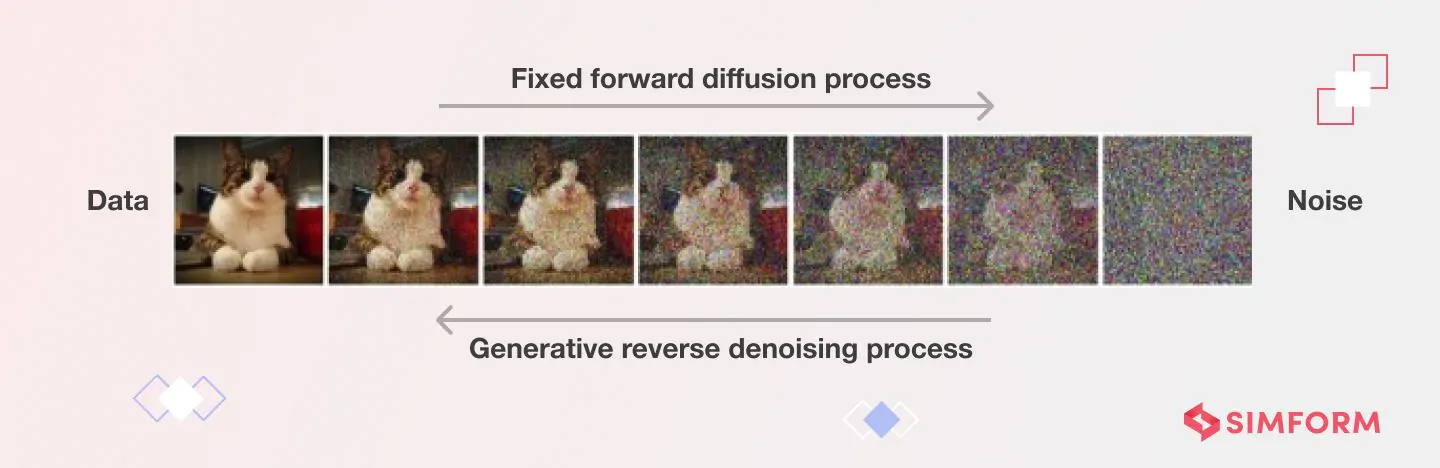

Anders als herkömmliche autoregressive Modelle, die Text Token für Token generieren, arbeitet Gemini Diffusion, indem es Rauschen durch wiederholte Schritte in zusammenhängenden Text umwandelt. Google behauptet, dass dieser Prozess Antworten liefert, die "deutlich schneller sind als selbst unser bisher schnellstes Modell".

"Das stellt eine grundlegende Verschiebung in der Art und Weise dar, wie wir über Sprachgenerierung nachdenken", sagte ein leitender KI-Forscher, der mit der Diffusionstechnologie vertraut ist, aber nicht mit Google verbunden ist. "Wir sehen das Potenzial für eine 4- bis 5-fache Verbesserung der End-to-End-Ausgabegeschwindigkeit im Vergleich zu autoregressiven Modellen ähnlicher Größe. Das ist so, als würde man nur durch Software-Innovation mehrere Hardware-Generationen überspringen."

Durchbrechen der sequenziellen Barriere

Die technische Innovation hinter Gemini Diffusion geht ein zentrales Problem aktueller KI-Systeme an. Traditionelle Sprachmodelle wie GPT-4 oder frühere Gemini-Versionen arbeiten sequenziell und sagen jedes Wort auf Basis dessen voraus, was zuvor kam. Dieser Ansatz ist zwar effektiv, begrenzt jedoch naturgemäß die Geschwindigkeit und kann bei längeren Ausgaben zu Problemen mit dem Zusammenhang führen.

Diffusionsmodelle verfolgen einen radikal anderen Ansatz. Anstatt Text Stück für Stück aufzubauen, beginnen sie mit zufälligem Rauschen und verfeinern es durch wiederholte Entrauschungsschritte schrittweise zu sinnvollen Inhalten.

"Der gesamte Prozess ähnelt eher dem Bildhauern als dem Schreiben", erklärte ein Branchenanalyst, der auf KI-Architekturen spezialisiert ist. "Das Modell berücksichtigt in jeder Verfeinerungsstufe den gesamten Kontext, was auf natürliche Weise Fehlerkorrekturen und eine ganzheitliche Kohärenz ermöglicht, die mit der Token-für-Token-Generierung schwieriger zu erreichen ist."

Von Google veröffentlichte Benchmark-Ergebnisse zeigen, dass Gemini Diffusion eine durchschnittliche Sampling-Geschwindigkeit von 1.479 Token pro Sekunde erreicht – eine deutliche Verbesserung gegenüber früheren Modellen. Dies geht jedoch mit etwa 0,84 Sekunden Verarbeitungszeit (Overhead) für jede Generierung einher.

Gemischte Benchmark-Ergebnisse zeigen Stärken und Schwächen

Googles Benchmark-Daten zeigen das ungleichmäßige, aber vielversprechende Leistungsprofil von Gemini Diffusion. Das Modell zeigt besondere Stärken bei Programmieraufgaben und erreicht 89,6 % bei HumanEval und 76,0 % bei MBPP – praktisch identisch mit den Ergebnissen von Gemini 2.0 Flash-Lite von 90,2 % bzw. 75,8 %.

In bestimmten Bereichen weist das Modell jedoch deutliche Schwächen auf. Beim BIG-Bench Extra Hard Reasoning-Test erzielte Gemini Diffusion 15,0 % im Vergleich zu 21,0 % bei Flash-Lite. Ebenso erreichte Diffusion beim Global MMLU mehrsprachigen Benchmark 69,1 % gegenüber 79,0 % bei Flash-Lite.

"Wir sehen hier eine Technologie, die bei Aufgaben hervorragend ist, die eine iterative Verfeinerung erfordern, wie z. B. Programmierung, wo kleine, lokale Anpassungen innerhalb eines globalen Kontexts wertvoll sind", bemerkte ein Experte für maschinelles Lernen bei einem großen Finanzinstitut. "Die schwächere Leistung bei Denkaufgaben deutet darauf hin, dass Diffusion für logikintensive Anwendungen eine architektonische Anpassung benötigt."

Trotz dieser Einschränkungen hebt Google DeepMind die Parameter-Effizienz des Modells hervor, das in vielen Bereichen vergleichbare Benchmark-Ergebnisse wie größere autoregressive Modelle erzielt.

Technische Herausforderungen bei Design und Implementierung von Text-Diffusionsmodellen

| Kategorie der Herausforderung | Spezifische Herausforderung | Beschreibung |

|---|---|---|

| Berechnung und Effizienz | Verarbeitungsanforderungen | Erfordert Hunderte bis Tausende von Entrauschungsschritten, von denen jeder einen kompletten Vorwärtsdurchlauf durch ein neuronales Netz beinhaltet |

| Latenzprobleme | Die Inferenz kann bemerkenswert langsam sein, was Echtzeitanwendungen einschränkt | |

| Speicherverbrauch | Deutliche Speicheranforderungen mit großen Zwischen-Feature-Maps während jedes Schritts der umgekehrten Diffusion | |

| Textspezifische Implementierung | Architekturbeschränkungen | Kann nicht von KV-Caching profitieren aufgrund nicht-kausaler Aufmerksamkeitsberechnung |

| Einschränkungen der Q_absorb-Übergänge | Token werden nur einmal entrauscht, was die Fähigkeit zur Bearbeitung zuvor generierter Token einschränkt | |

| Verarbeitungsinneffizienzen | Maskierte Token liefern keine Information, verbrauchen aber trotzdem Rechenressourcen | |

| Feste Generierungslänge | Großes Hindernis für offene Textgenerierung im Vergleich zu autoregressiven Modellen | |

| Kontrolle und Ausrichtung | Probleme mit der Textgenauigkeit | Schwierigkeiten, eine vollständige Menge von Bedingungen einzuhalten, die im Eingabetext spezifiziert sind |

| Probleme mit der Treue | Generieren oft Inhalte mit falscher Bedeutung oder falschen Details trotz natürlich aussehender Ausgabe | |

| Inkonsistente Ausgaben | Unterschiedliche zufällige Stichproben können sehr unterschiedliche Ergebnisse mit demselben Prompt produzieren | |

| Text-Rendering | Schwierigkeiten beim Rendern von korrektem Text und bei der Kontrolle des Textstils in der Bilderzeugung | |

| Theoretisches und Lernen | Herausforderungen bei der Score-Funktion | Leistung ist an das genaue Erlernen der Score-Funktion gebunden |

| Abwägung von Kompromissen | Das Finden eines optimalen Gleichgewichts zwischen Geschwindigkeit, Kosten und Qualität bleibt ungelöst | |

| Bereitstellung (Deployment) | Ressourcenbeschränkungen | Begrenzter Rechen-Durchsatz, Speicherkapazität und Energiebudget auf Edge Devices |

| Thermomanagement | Viele Geräte verlassen sich auf passive Kühlung, was anhaltende Workloads mit hohem Durchsatz unpraktisch macht | |

| Produktionsintegration | Umgang mit variabler Latenz und hohem Speicherverbrauch erschwert die Systemintegration | |

| Sicherheitsbedenken | Missbrauch verhindern erfordert robuste Schutzmaßnahmen, die zusätzlichen Aufwand verursachen | |

| Versionskontrolle | Updates können nachgelagerte Anwendungen beschädigen, wenn für spezifische Anwendungsfälle feinabgestimmt wird |

Bearbeitung und Verfeinerung: Eine neue KI-Stärke

Der vielleicht bedeutendste Vorteil des Diffusionsansatzes ist seine natürliche Eignung für Bearbeitungs- und Verfeinerungsaufgaben.

"Bei jedem Entrauschungsschritt kann das Modell sachliche oder syntaktische Fehler selbst korrigieren", sagte ein Informatikprofessor, der generative KI erforscht. "Das macht Diffusion besonders leistungsfähig für Aufgaben wie mathematische Ableitungen oder Code-Korrekturen, bei denen man die Konsistenz über komplexe Beziehungen hinweg wahren muss."

Diese Selbstkorrekturfähigkeit bietet eine potenzielle Lösung für Herausforderungen wie Halluzinationen und Abweichungen, die große Sprachmodelle geplagt haben. Indem Gemini Diffusion bei jedem Schritt die gesamte Ausgabe berücksichtigt und nicht nur die vorhergehenden Token, kann es bei längeren Passagen eine bessere Kohärenz wahren.

Früher Zugang und zukünftige Auswirkungen

Google hat eine Warteliste für Entwickler eröffnet, die an der Erprobung von Gemini Diffusion interessiert sind. Es wird als "experimentelle Demo zur Entwicklung und Verfeinerung zukünftiger Modelle" beschrieben.

Für professionelle Anwender und Investoren reichen die Auswirkungen weit über eine einzelne Produktveröffentlichung hinaus. Diffusionsmodelle könnten die KI-Landschaft grundlegend verändern, wenn sie weiterhin Vorteile bei Geschwindigkeit und Qualität zeigen.

"Wir sehen möglicherweise den Beginn einer Hybrid-Ära", schlug ein KI-Investmentstratege bei einem großen Hedgefonds vor. "Die nächsten zwei Jahre könnten von Modellen dominiert werden, die die Geschwindigkeit und Kohärenz von Diffusion mit den Stärken des Token-basierten Denkens autoregressiver Ansätze kombinieren."

Die Technologie erscheint besonders vielversprechend für interaktive Bearbeitungswerkzeuge, bei denen Benutzer KI-Ausgaben während der Generierung verfeinern oder Einschränkungen dynamisch anwenden könnten. Dies könnte eine präzisere Kontrolle ermöglichen, als es das derzeitige Ein-Schuss-Prompt-Engineering zulässt.

Markt Auswirkungen der Diffusionsverschiebung

Für Händler und Investoren, die den KI-Bereich beobachten, stellt Gemini Diffusion sowohl eine Chance als auch eine Umwälzung dar.

"Diese Innovation verschiebt die Kostenkurve für Inferenz im großen Maßstab", sagte ein Analyst des Technologiesektors. "Unternehmen, die stark in auf Autoregression optimierte Infrastruktur investiert haben, müssen sich möglicherweise neu ausrichten, während diejenigen, die an Bearbeitungsfähigkeiten und interaktiven KI-Erlebnissen arbeiten, ihre Position gestärkt sehen könnten."

Die Ankündigung signalisiert einen verschärften Wettbewerb im KI-Wettlauf, bei dem Google seine Forschungstiefe nutzt, um seine Angebote von denen von OpenAI, Anthropic und anderen zu differenzieren. Für Unternehmenskunden könnte das Versprechen schnellerer Generierung bei vergleichbarer Qualität die Rechenkosten erheblich senken.

Es bleiben jedoch erhebliche Hindernisse, bevor Diffusionsmodelle Mainstream werden könnten. Das Ökosystem von Werkzeugen, Sicherheitsaudits und Best Practices für die Bereitstellung von Text-Diffusion ist weit weniger ausgereift als für autoregressive Modelle. Frühanwender könnten mit Integrationsherausforderungen und ungleichmäßiger Qualität über verschiedene Bereiche hinweg konfrontiert sein.

"Die große Frage ist, ob Text-Diffusion die Zukunft ist oder nur ein wichtiger Bestandteil davon", bemerkte ein Experte für KI-Governance. "Der Erfolg wird wahrscheinlich Systemen gehören, die Diffusion mit Token-basiertem Denken, Informationsabruf (Retrieval) und robusten Sicherheitsebenen kombinieren."